當前位置:首頁>科技> OpenAI 發(fā)布新模型 奧特曼:耐心時刻結束了

發(fā)布時間:2026-01-17閱讀( 5)

北京時間凌晨一點,OpenAI 突然進行了重大更新。

已經預熱了接近一年的 Q*/草莓項目,cs中能夠進行高級推理的大語言模型,今晚終于露出了真面目。

OpenAI 發(fā)推表示,剛剛推出了 OpenAI o1-preview 模型——名字的含義之前外媒已經爆料過,o1 應該代表著 OpenAI 下一代大模型的 Orion(獵戶座)一代。

OpenAI 在發(fā)布文檔中寫道,新模型在推理能力上代表了人工智能能力的新水平,因此,計數(shù)器將重置為 1 ——這意味著未來很可能不會有 GPT-5 了,o1 將代表未來 OpenAI 的最強水平。

且從今天開始,ChatGPTPlus 和 Team 用戶就能夠直接訪問模型。

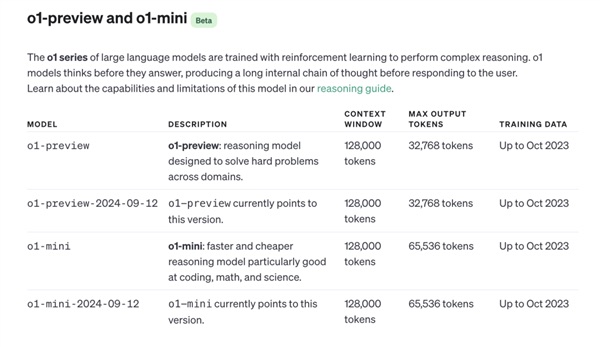

用戶可以手動選擇使用 o1 模型的預覽版——o1-preview,或者使用 o1 模型的小尺寸版——o1-mini。o1-preview 的每周限制為 30 條消息,o1-mini 的每周限制為 50 條。

在 OpenAI 的模型介紹網頁上,可以看到 o1 模型的訓練數(shù)據(jù)截止時間為去年十月份,而最早的 Q*項目的爆料,正好大概出現(xiàn)在去年十一月份。

OpenAI 憋了一年的大招究竟如何?OpenAI 能否再一次引領大模型的潮流,甚至讓人們看到通用人工智能之路不再遙遠?很快,每個人都能檢驗這一點了。

Sam Altman 凌晨一點在 X 上發(fā)帖:「需要耐心等待的時刻結束了!」

o1 模型:解決博士級別的科學問題超越人類

截止發(fā)稿時,筆者還不能使用 o1 模型。

不過 OpenAI 已經放出了大量相關的 o1 模型表現(xiàn)展示。#母愛的詩句#

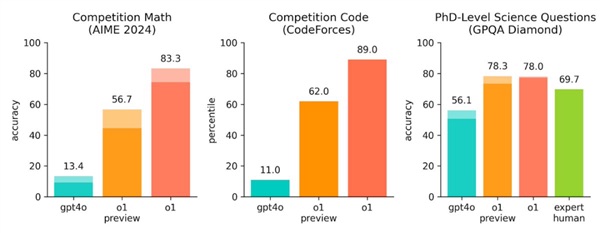

最引人關注的當然是新模型的推理能力。Sam Altman 直接在 X 上貼出了 o1 與 GPT-4o 在數(shù)學、編程和解決博士級別科學題目上的能力對比。

最左邊的柱形代表目前 OpenAI 的主力模型 GPT-4o。今天放出來的 o1 預覽版為中間的橙色柱形。#本王在此#

可以看到,在 2024 年美國數(shù)學邀請賽的競賽題和 Codeforces 算法競賽題上,o1 預覽版解決數(shù)學和編程問題的能力,比起 GPT-4o,提升了 5-6 倍。#賀知章#而可怕的是,深橙色的柱形,代表真正的 o1,相比于 GPT-4o,提升了 8-9 倍!

最后一個圖中,OpenAI 還列出了人類專家在解決博士級別科學題目的時的成功率,大約在 69.7%,而 o1 預覽版和 o1,都已經超過了人類專家的水平。

OpenAI 的技術博客提到了更具體的數(shù)字,目前 o1 模型的成績,在美國數(shù)學邀請賽上,可以排名進入美國前 500 名。而物理、生物和化學問題上的準確度,超過了人類博士的水平。#英雄聯(lián)盟uzi#

在大模型技術進入公眾視野的兩年內,一個經常為人們所使用的比喻是,大模型像一個什么都懂一點的大學生,在知識專精方面遠遠不行,但是從天文到地理,最基礎的知識都能懂一點點。#抖音創(chuàng)始人張一鳴簡介 程序員可以逆襲成為商人#OpenAI 的新模型,很有可能要刷新人們的這一認知了。

在官方博客中,OpenAI 簡單解釋了這一進步背后的原理。

類似于人類在回答難題之前可能會思考很長時間,o1 在嘗試解決問題時會使用一系列思維。通過強化學習,o1 學會了磨練其思維鏈并完善其使用的策略。它學會了認識并糾正錯誤,將棘手的步驟分解為更簡單的步驟。當當前方法不起作用時,它會嘗試另一種方法。這個過程極大地提高了模型的推理能力。

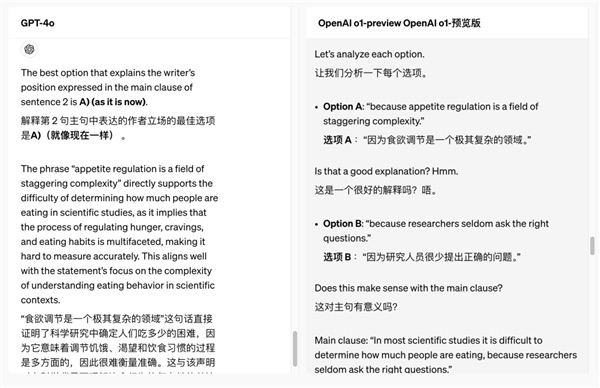

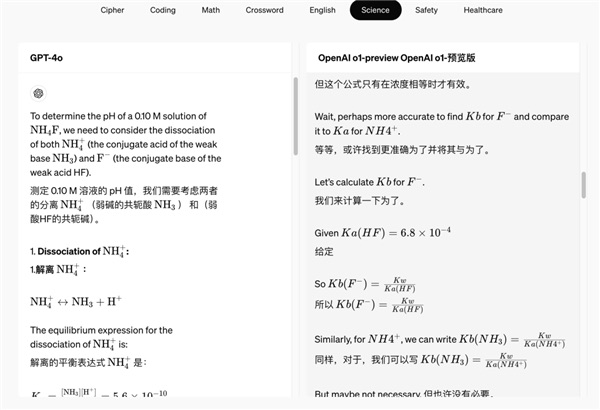

在 OpenAI 給的案例中。GPT-4o 和 o1 模型同時回答同一個問題——讀一段長文,然后做閱讀理解。#大樹媽媽歌曲#在 o1 模型中,會多一個選項叫做展開思維鏈。

如果不展開思維鏈,我們可以看到兩個模型本身給出的答案是不同的。而打開思維鏈后,則會看到一段非常長的模型和自己的思維對話,解釋為什么做出了不同的選擇。

選 A 嗎?emm,好像不是很好。選 B 嗎?好像沒有關聯(lián)。模型完全在自己和自己提問和回答,最后判斷出了哪個答案更好。

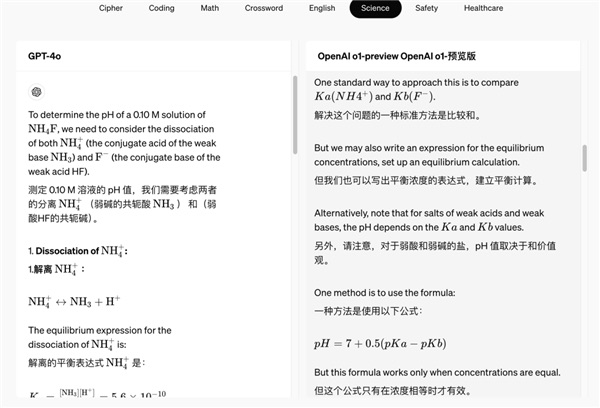

而在另一個例子中,解決化學問題時,我們可以看到 o1 模型甚至自己在選擇多種方案對比。

標準的計算方式是這樣。但是我們也可以這么計算,但這樣或許沒有必要?

在多次糾正自己之后,它得出了正確的答案。

之前,也已經有很多報道透露過 o1 模型能夠有高推理能力的原理——這一訓練方法,最早來自于斯坦福大學 2022 年開發(fā)的一種「自學推理」(Self-Taught Reasoner,STaR)。

后來研究人員進一步開發(fā)了一種名為"Quiet-STaR"的新技術,翻譯過來大概為"安靜的自學推理"。核心為在每個輸入 token 之后插入一個"思考"步驟,讓 AI 生成內部推理。然后,系統(tǒng)會評估這些推理是否有助于預測后續(xù)文本,并相應地調整模型參數(shù)。這也是人們推測 OpenAI 最早的模型項目為什么叫 Q*(讀作 Q Star)的原因。

在 o1 模型出現(xiàn)之前,用戶通常也可以自己通過和模型對話的方式,讓模型進行一步一步的思考,也就是所謂的慢思考,進行更準確的回答。但是很明顯,o1 模型此次將思維鏈放大到了完全不同的量級上。

而且,在之前的用戶 prompt 引導中,模型能夠回答出什么答案,最終也還要被模型能力限制。而通過不同的訓練方式訓練出來的 o1 模型,很有可能能夠通過自己的推理,超越自身訓練材料的限制,產出更高級和準確的答案。

在復雜推理任務上的進步,可能對編程和科學研究兩個方向產生直接的推動。

OpenAI 提到,在未來,醫(yī)療保健研究人員可以使用 o1 來注釋細胞測序數(shù)據(jù),物理學家可以使用 o1 生成量子光學所需的復雜數(shù)學公式,所有領域的開發(fā)人員可以使用 o1 來構建和執(zhí)行多步驟工作流程。

OpenAI提供了一個例子,真正做到了只使用提示詞,就完成了一個游戲的編程。

而推理能力的進步,如果能夠進一步消除模型的幻覺,還可能對 AI 應用的建構產生間接的影響。對未來的AI安全也有積極的影響——之前的一些通過提示詞工程誤導模型進行錯誤輸出的手段,可能會直接被模型通過更強的思考能力解決。

OpenAI o1-preview 將在今天開始能夠在 ChatGPT 上使用,并提供給受信任的API用戶。

價格沒漲,OpenAI 用 o1-mini 解決推理成本問題

在 OpenAI 此次發(fā)布之前,曾有不少媒體爆料,新模型因為內部推理鏈條較長,對于推理的算力成本的需求進一步增高,OpenAI 很有可能將提高使用模型的費用,甚至最離譜的猜測數(shù)字達到每月 2000 美金。

而此次 OpenAI 的發(fā)布,卻令人驚訝,新模型的使用價格并沒有上漲,雖然因為推理成本的原因,使用次數(shù)受到了大大的限制。o1-preview 的每周限制使用條數(shù)為 30 條消息。

除了限制使用條數(shù),OpenAI管控推理成本的另一個重要舉措,是隨著 o1 模型的推出,同時推出了 o1-mini 版。

OpenAI 沒有具體說明 o1-mini 的參數(shù)量有多大,但通過技術文檔可以看出,o1mini 版,和 o1 版上下文長度沒有區(qū)別,甚至最大輸出 token 數(shù)更高。

OpenAI 表示 o1-mini 尤其擅長準確生成和調試復雜代碼,對于開發(fā)人員尤其有用。作為較小的模型,o1-mini 比 o1-preview 便宜 80%,這使其成為需要推理但不需要廣泛的世界知識的應用程序的強大且經濟高效的模型。

OpenAI 甚至還計劃之后為所有 ChatGPT 免費用戶提供 o1-mini 訪問權限。

不過,作為新模型,o1 系列模型,目前仍然不能瀏覽網頁以獲取信息以及上傳文件和圖像。OpenAI 也提示道,GPT-4o 在短期內,在某些任務上會更強一些。

Scaling Law 后最重要的進展?

事實上,此次發(fā)布了新的模型,甚至不是 OpenAI 的發(fā)布中唯一重要的事情。

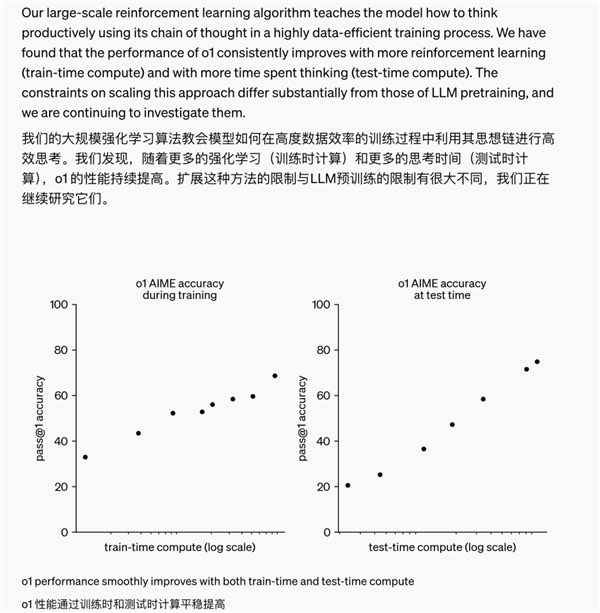

OpenAI 還提及了自己訓練中發(fā)現(xiàn)的一個現(xiàn)象:隨著更多的強化學習(訓練時計算)和更多的思考時間(測試時計算),o1 的性能能持續(xù)提高。擴展這種方法的限制與 LLM 預訓練的限制有很大不同。

事實上,英偉達的具身團隊領導者 Jim Fan 直接在 X 上點評了這一事件的歷史意義——模型不僅僅擁有訓練時的 scaling law,還擁有推理層面的 scaling law,雙曲線的共同增長,將突破之前大模型能力的提升瓶頸。

Jim Fan 表示,2022 年,人們提出了原始的 scaling law(尺度定律),大概意為隨著模型的參數(shù)量、數(shù)據(jù)量和計算量的增加,模型的性能能夠不斷提高。

這指的是在模型的訓練過程中。而 scaling law 在今年看起來,似乎已經有停滯的意味——他提到在 self-rewarding language 文章中,感受到 3 輪自我提升似乎是大語言模型的飽和極限了。

而此次 OpenAI 新模型,除了在訓練時,通過增大參數(shù)量和數(shù)據(jù)量,得到了性能上的提升,同時通過增加推理時間——也就是前面所說的模型在自我內部思考的時間——得到了能力上的提升。

也就是說,如果模型未來自己和自己思考的時間越長,得到的答案可能會越準確。這很接近于我們對AI的終極想象了——像最早在 AlphaGo 中所展現(xiàn)出來的,AI 通過自己和自己下棋,提升自己的棋藝。

OpenAI 的新模型,展現(xiàn)出的,是一條新的大模型的提升路徑。

Jim Fan 在 X 上的一句話令人聳動:「之前,沒人能將 AlphaGo 的成功復制到大模型上,使用更多的計算讓模型走向超人的能力。目前,我們已經翻過這一頁了。」

回看 2023 年,許多人在問,Ilya 看到了什么?

大家都懷疑是一個超級強有力的模型——是的,此次發(fā)布的 o1 模型確實很強。

但或許,更有可能是這個——推理層面的 scaling law 的發(fā)現(xiàn),再一次讓人們意識到,超人的AI,或許不再遙遠。

Copyright ? 2024 有趣生活 All Rights Reserve吉ICP備19000289號-5 TXT地圖HTML地圖XML地圖